#31 : Comment espionner les Ads de ses concurrents automatiquement

Fini la panne d'inspiration ! Ton espion récupère automatiquement les Meta ads de tes concurrents et les stock pour te constituer un dossier d'inspiration.

Introduction

👋 Hello tout le monde !

Aujourd'hui, on ne va pas seulement automatiser une tâche, on va construire un véritable système de veille stratégique : un Espion Meta Ads.

Le but d'un tel outil est :

Comprendre ce qui fonctionne dans ton secteur.

Analyser les angles marketing et les arguments de tes concurrents.

Générer des idées pour tes propres campagnes.

Ne plus jamais repartir d'une page blanche.

Référencer les influenceurs qui travaillent avec tes concurrents

Découvrons ensemble comment mettre en place un tel système !

📊 L'idée ?

On va construire un système capable de :

Scanner les publicités d'une liste de concurrents que l'on définit dans Airtable.

Filtrer automatiquement les pubs déjà vues pour ne garder que les nouveautés.

Catégoriser les pubs selon leur format (Vidéo, Image, DCO/Carrousel).

Se constituer une bibliothèque d’ads de nos concurrents (image ou vidéo).

Stocker le tout proprement dans une base de données Airtable qui devient notre tableau de bord de veille.

Imagine avoir une source d'inspiration infinie et de haute qualité, mise à jour en pilote automatique.

🙏 Un petit coup de pouce ?

Teste Make.com (ou n8n) via mes liens partenaires si tu veux me soutenir.

Bloque un créneau avec moi pour qu'on discute de tes projets d'automatisation.

Propose une idée de scénario qui pourrait devenir le sujet d’un prochain article.

🛠️ Ma boîte à outil

Retrouve les outils que je préfère utiliser sur maketime.fr/mes-outils.

📁 Gumroad

Comme pour les outils, mes blueprints sont désormais disponibles sur mon site : https://www.maketime.fr/blueprints

Le blueprint de ce scénario est disponible sur Gumroad.

💡 Pour ceux ne connaissant pas, les blueprints permettent d’importer l’ensemble des modules avec leurs paramétrages (comme les prompts OpenAI) des scénarios Make.com. Il suffit de créer un nouveau scénario, cliquer sur les trois petits points dans la barre du bas et "Import blueprint".👁️ Présentation du scénario

✅ Quel est l’objectif du scénario ?

L'objectif est simple : créer une machine de veille concurrentielle qui travaille pour nous. Fini de scroller manuellement la bibliothèque publicitaire de Facebook.

Ce workflow va chercher les publicités de nos concurrents, s'assure qu'elles sont nouvelles, et les archive dans une base de données Airtable structurée et exploitable.

Le but ?

Transformer une tâche de recherche manuelle et fastidieuse en une source de créativité et de stratégie organisée.

⚙️ Comment fonctionne ce scénario ?

Listing des Cibles (Airtable) : Le scénario démarre en lisant une table Airtable où l'on a listé nos concurrents. Simple et efficace pour ajuster la veille sans toucher au scénario.

Scraping (Apify) : Pour chaque concurrent, Make envoie une requête à Apify pour récupérer les dernières publicités. J'utilise une méthode asynchrone : Make lance la tâche, attend 30 secondes, puis va chercher les résultats.

Filtre Anti-Doublons : C'est le gardien du temple ! Pour chaque pub trouvée, un module Airtable vérifie si son ID est déjà dans notre base. Si c'est le cas, le filtre arrête le traitement pour cette pub.

Tri Intelligent (Router) : Le module Router analyse chaque nouvelle publicité et l'oriente vers la bonne branche du workflow en fonction de son format : Vidéo, Image, ou DCO (format carrousel).

Archivage du Média et des Données : Chaque branche suit une logique similaire :

Un module HTTP télécharge le fichier (image ou vidéo).

Un module Google Drive stocke le fichier pour obtenir une URL stable (une petite astuce bien pratique).

Un module Airtable final crée une nouvelle ligne dans notre base avec toutes les informations : nom du concurrent, texte de l'annonce, type de format, et bien sûr, le visuel en pièce jointe.

🛠️ Quelles applications sont nécessaires pour cet espion ?

Make.com : Notre outil d’automatisation, parfait pour ce type de workflow.

Apify : Pour scraper la bibliothèque publicitaire de Facebook.

Airtable : Notre base de données et centre de commandement.

Google Drive : Utilisé comme solution de stockage pour les médias.

💰 Quel est le coût estimé du scénario ?

Make.com : Le plan gratuit peut suffire pour démarrer avec un ou deux concurrents. Les plans payants commencent à 9$/mois.

Airtable : Le plan gratuit est largement suffisant pour stocker des milliers de publicités.

Apify : Très abordable. Le scraper de la bibliothèque publicitaire coûte environ 0,75$ pour 1000 pubs scrapées. On est donc sur quelques centimes par exécution.

👀 Le résultat

🧑🏫 Etapes pour créer ce scénario

Étape 0 : La Préparation du Terrain

Avant même de poser le premier module, assurons-nous que notre base est prête.

Crée une base Airtable avec deux tables :

Table 1 : Concurrents

Nom (Champ Texte)

URL de recherche FB Ad Library (Champ URL)

Comment trouver cette URL ? Va sur la bibliothèque publicitaire de Meta, cherche un de tes concurrents, et copie simplement l'URL de la page de résultats.

Table 2 : Annonces

Ad Archive ID (Champ Texte)

Concurrent (Champ Lien vers la table Concurrents)

Type (Champ Texte)

Contenu (Champ Texte)

Nom de page (Champ Texte)

Visuel (Champ Pièce Jointe)

Texte ads (Champ Texte Long)

URL de redirection (Champ URL)

Remplis ta table Concurrents avec au moins une ou deux entreprises à surveiller pour pouvoir tester.

Étape 1 : Lister nos Cibles

⚙️ Module : Airtable > Search Records

C'est le premier module de notre scénario. On pourra le lancer une fois par jour ou une fois par semaine en fonction de l’intensité de tes concurrents.

Connection : Connecte ton compte Airtable.

Base : Choisis ta base Veille Concurrentielle.

Table : Choisis la table Concurrents.

Limit : Tu peux mettre "10" ou plus, selon le nombre de concurrents que tu as.

🧠 Le but ? Ce module va simplement récupérer la liste de tous les concurrents que tu as renseignés dans Airtable pour les donner au module suivant.

Étape 2 : Lancer le Scraping pour Chaque Concurrent

Maintenant, on veut scraper les ads de chacun de nos concurrents.

⚙️ Module : Apify > Run Actor

Connection : Connecte ton compte Apify.

Actor : Recherche et sélectionne curious_coder/facebook-ads-library-scraper.

Run synchronously : En mettant “Yes” le scénario reste en run tant qu’il n’a pas fini de scrapper. Je te conseille donc de le cocher.

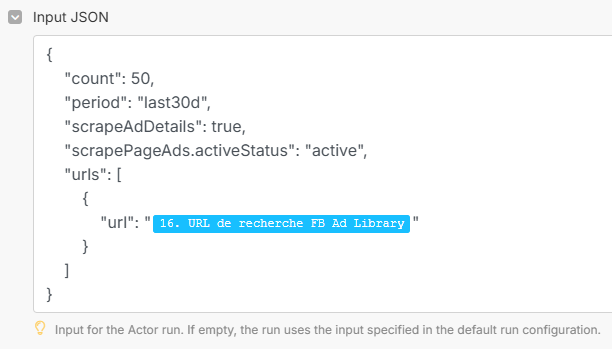

Input JSON : C'est ici qu'on donne les ordres. Copie-colle ce JSON :

{

"count": 50,

"period": "last7d",

"scrapeAdDetails": true,

"urls": [

{

"url": ""

}

]

}Ici on lui dit de récupérer 50 ads sur la période des 30 derniers jours.

Tu peux augmenter les 50 ads pour le premier run et ensuite mettre moins et récupérer sur la période des 7 derniers jours.

⚙️ Module : Apify > Get Dataset Items

Dataset ID : Mappe la variable defaultDatasetId qui vient du module Apify > Run Actor.

🧠 Le but ? Maintenant que le travail est fait, on retourne chez Apify pour récupérer le fruit de sa collecte : la liste des publicités.

Étape 3 : Le Gardien

On a une liste de pubs, mais certaines sont peut-être déjà dans notre base. On ne veut que les nouveautés !

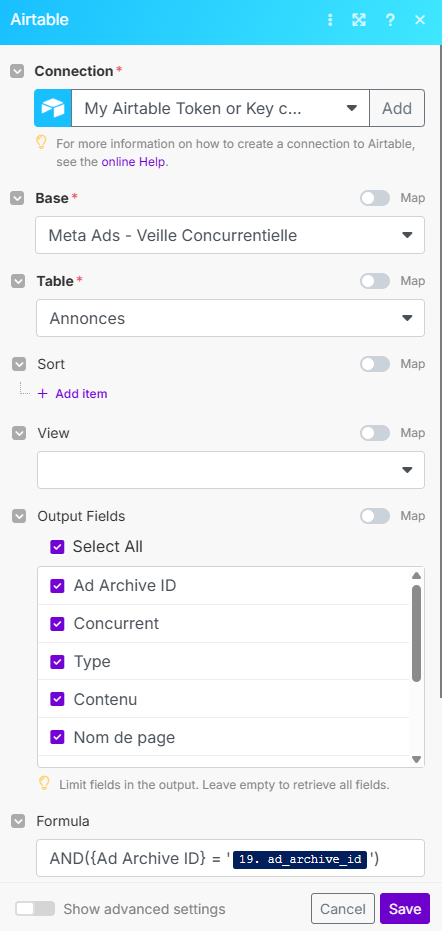

⚙️ Module : Airtable > Search Records

Base : Veille Concurrentielle, Table : Annonces.

Output Fields : Coche l’ensemble des champs

Formula : On interroge notre base Airtable afin de savoir si un ID d’ads que nous avons récupéré match avec un ID que nous avons déjà.

🛡️ Le Filtre : Maintenant, clique sur le lien qui part de ce module vers le suivant. Une option "Set up a filter" apparaît.

Label : "Continuer si Nouvelle Ad"

Condition : Mappe la variable Total number of bundles du module Airtable que tu viens de créer.

Opérateur : Choisis Numeric operators: Equal to.

Valeur : 0.

Le scénario ne continuera que si la recherche dans Airtable n'a retourné AUCUN résultat (total = 0), donc si l'annonce est bien nouvelle.

Étape 4 : Le Centre de Tri

⚙️ Module : Flow Control > Router

Place ce module après le filtre. Il va créer plusieurs chemins pour nos données. On va en faire 3 : Vidéo, Image, DCO.

Sur le chemin du haut, crée un filtre :

Label : "Vidéo"

Condition : Mappe la variable snapshot.display_format.

Opérateur : Text operators: Contains to (case insensitive).

Valeur : video

Sur le chemin du milieu, crée un autre filtre :

Label : "Image"

Condition : Mappe la variable snapshot.display_format.

Opérateur : Text operators: Contains (case insensitive).

Valeur : image

Sur le chemin du bas, tu fais la même chose mais avec “DCO”

Étape 5 : L'Archivage

Exemple avec la branche "Image"

Chaque branche va faire la même chose : télécharger le média et l'enregistrer dans Airtable. Prenons l'exemple de la branche "Image".

⚙️ Module 1 (dans la branche) : HTTP > Get a file

URL : Mappe la variable.

⚙️ Module 2 : Google Drive > Upload a file

Connection : Connecte ton Google Drive.

Destination : Choisis un dossier (ex: un dossier "Librairie Meta Ads").

Source file : Choisis le module HTTP précédent.

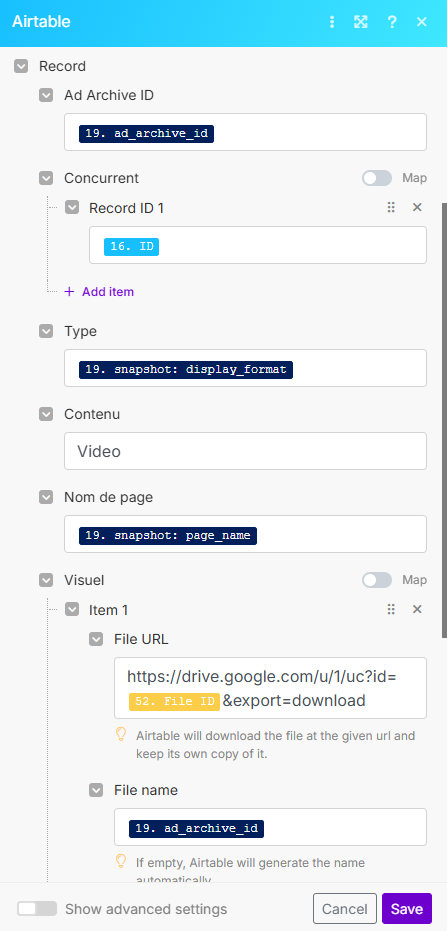

⚙️ Module 3 : Airtable > Create a Record

C'est le dernier module de la branche. On rassemble tout ici.

Reprends cette logique pour les autres branches (Vidéo et DCO), en mappant les bonnes variables de vidéo ou de carrousel et en changeant le champ Type en conséquence.

🏁 Et voilà, ton espion ads est prêt à infiltrer la librairie Facebook 🏁

Ce workflow est un bon exemple de la puissance d’APIFY, permettant de scrapper beaucoup de data de manière automatisée grâce à Make.

C'est une machine à idées, un décodeur de stratégies, et un gain de temps phénoménal. Adapte-le à ton secteur, lance-le une fois par semaine, et tu ne seras plus jamais à court d'inspiration.

Merci pour le travail ! C’est fou :) Peut-être une piste pour renforcer le scénario, rajouter une surcouche d’ia pour faire une synthèse des best practices des concurrents etc. Mais sinon vraiment top, hâte d’essayer ça !